La Tesla Model 3 Autopilot che si schianta contro un furgone ribaltato su un’autostrada di Taiwan riaccende la discussione sulle auto a guida autonoma.

Guida autonoma e Tesla

La prospettiva di auto che guidino completamente da sole, infatti, affascina e divide da anni.

La Tesla ne ha fatto un argomento di innovazione e di marketing molto potente, capace di cambiare completamente le motivazioni di scelta dei suoi clienti.

L’innovazione per chi sceglie una Tesla è al primo posto. Non spaventa, come succede in altri casi. Al contrario, rappresenta una forte motivazione di acquisto.

Amore e odio

Ecco perchè gli incidenti delle Tesla in modalità Autopilot (reale o presunta) fanno così tanto clamore.

Oltre alla trazione esclusivamente elettrica, la capacità automatica di supporto alla guida è una caratteristica peculiare di una Tesla.

Amata da chi la ama, odiata da chi la odia.

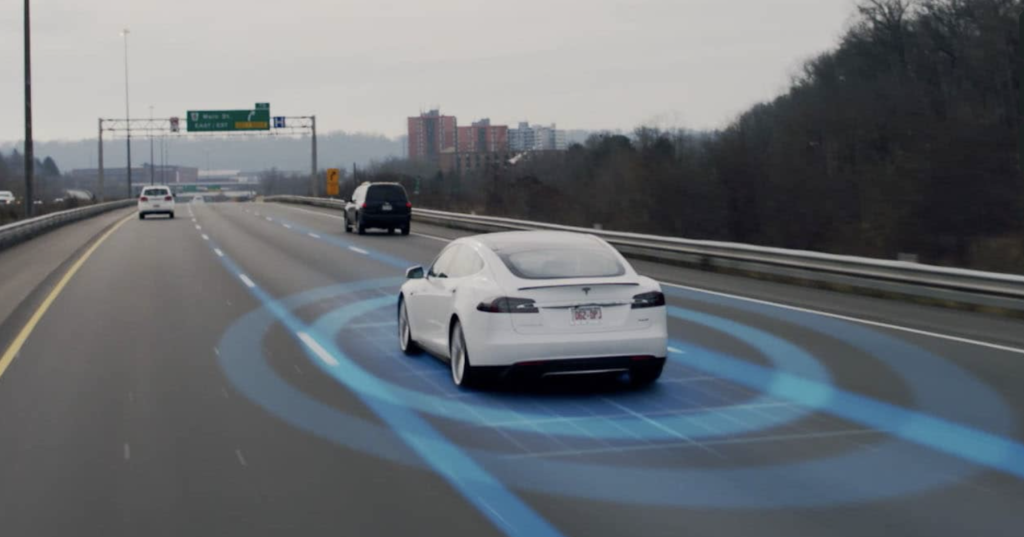

Cos’è il Tesla Autopilot

La tecnologia Autopilot della Tesla Model 3 non prevede che il conducente possa distrarsi alla guida.

La casa costruttrice informa chiaramente i suoi clienti sul fatto che chi è al volante, anche quando attiva la modalità di supporto Autopilot, non deve togliere gli occhi dalla strada.

L’Autopilot è un sistema per il mantenimento automatico di corsia e distanza. Non è un sistema di guida autonoma o automatica del veicolo. Non ancora.

Però l’incidente apre comunque una riflessione su come sia potuto succedere che l’auto – se è vero che stava viaggiando in modalità Autopilot, come affermato dal conducente – non abbia minimamente individuato un ostacolo così grande e completamente fermo in mezzo alla strada.

Come funziona il Tesla Model 3 Autopilot

Il sistema di assistenza alla guida della Tesla Model 3 è uno dei più avanzati presenti sul mercato ed è quello col maggior numero di chilometri di test analizzati, vista la sua diffusione sulle Tesla e la frequenza con cui gli utilizzatori lo attivano.

L’Autopilot Tesla conta ad oggi oltre 5 miliardi di chilometri di dati raccolti.

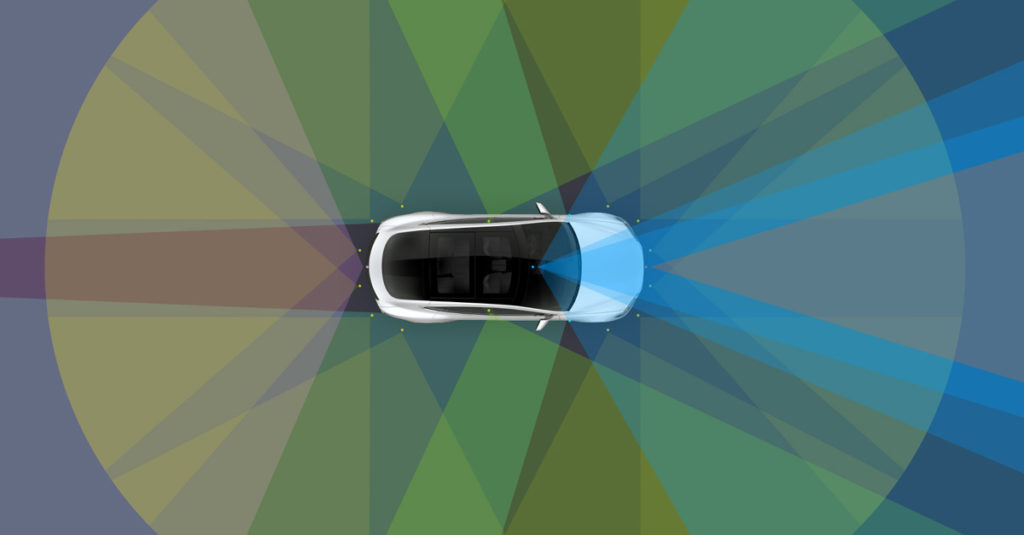

Il sistema si basa su diverse tecnologie e ha una logica di elaborazione dei dati dotata addirittura di elementi di intelligenza artificiale.

Ecco cos’è successo a Taiwan

Le due componenti chiave nel caso di Taiwan, vista la velocità autostradale e la distanza del furgone ribaltato quando diventa individuabile, sono il radar e le videocamere anteriori.

Ognuna delle due, anche singolarmente, è in grado di individuare e riconoscere quell’ostacolo.

Guasto più errore tecnico

Quello che è successo può essere quindi dovuto al mancato funzionamento di una delle due e al contemporaneo errore dell’altra.

L’errore può essere originato dal materiale con cui è costruito il cassone del furgone, dall’inclinazione della superficie visibile rispetto all’auto, oppure anche dal colore chiaro. Di nuovo, nessuno di questi elementi basta da solo a spiegare l’accaduto.

Però un ulteriore problema nel successivo flusso di elaborazione delle informazioni, relativo proprio alle verifiche incrociate tra dati video e dati radar, può aver portato al patatrac.

Errore umano

Senza dimenticare che tutto ciò si basa sull’affermazione del guidatore, che sostiene che l’Autopilot fosse in funzione.

L’altra possibilità, tutt’altro che remota, è che l’errore sia proprio suo e l’Autopilot non fosse affatto inserito. Perlomeno non correttamente.

L’ipotesi di guasto più probabile

Se non si tratta di errore umano ed è vero che il sistema Autopilot era attivo, l’ipotesi di guasto più probabile, conoscendo le tecnologie sulle quali si basa il Tesla Model 3 Autopilot, riguarda il radar.

Radar

Se il radar avesse funzionato correttamente, già alla distanza di 150 metri l’auto avrebbe rallentato. Se non l’ha fatto, il radar non era probabilmente funzionante.

Videocamere

Le videocamere probabilmente erano invece funzionanti, ma il fatto che l’auto Tesla Model 3 sia la prima ad arrivare sull’incidente non fornisce elementi aggiuntivi di analisi che sono spesso decisivi.

Non ci sono, cioè, altre auto che evitano l’ostacolo prima della Tesla Model 3. Se ci fossero state, anche la Tesla Model 3 Autopilot avrebbe rallentato e scartato il furgone.

Le videocamere da sole, comunque, sono in grado di riconoscere l’ostacolo e secondo me lo hanno individuato.

Analisi incrociata dei dati

Però nella successiva verifica, che incrocia i dati delle videocamere con quelli del radar (che nell’ipotesi che faccio sono assenti, essendo il radar fuori uso) è successo qualcosa.

Non essendo presenti dati di verifica, il sistema avrebbe dovuto prendere per valida la lettura delle videocamere e frenare.

Materiale del cassone, inclinazione, colore chiaro

Non bastano il materiale del cassone – probabilmente sintetico, visto come viene sfondato dalla tesla Model 3 nell’impatto – né l’inclinazione della superficie visibile, né il colore chiaro a giustificare la mancata frenata.

Il sistema se le videocamere erano anche soltanto in parte funzionanti, ha sicuramente individuato l’ostacolo.

Il bug nel software

Mentre io scrivo, certamente gli ingegneri di software della Tesla stanno verificando se esiste un bug, cioè un difetto o una mancanza di programmazione nel codice che governa l’Autopilot.

Il difetto va cercato nell’incrocio tra dati deboli (qui possono avere un ruolo il materiale, l’inclinazione, il colore chiaro e simile allo sfondo) in arrivo dalle videocamere, con dati assenti (per l’ipotizzato malfunzionamento) del radar.

Quello è il punto del sistema che può aver causato l’incidente.

Clicca qui e leggi l’articolo con VIDEO Robotaxi, il business dell’auto a guida autonoma.